近年、放射線診断や放射線治療において、医用画像位置合わせは重要な技術になってきています。ここでは、医用画像位置合わせに興味のある学生、研究者向けに、医用画像位置合わせに必要な基礎知識をまとめて紹介しています。

今回は、前回に引き続き、医用画像の位置合わせにおいて用いられる「画像の類似度の指標」についてですが、その中でも特に、異なるモダリティで撮影された画像同士の位置合わせに用いられる「相互情報量」について紹介します。もともと「相互情報量」は、情報通信分野で用いられる用語ですが、これがどのように、画像解析に関係してくるのでしょうか?

実際のMRI画像を用いて相互情報量を計算してみようと思いますが、今回は、その下準備として、「情報量」と「エントロピー」の考え方について簡単に説明します。

① 情報量とエントロピー

情報とは、端的に言えば「そのことを知ることによって、ある物事が起こる不確実さを減らすもの」です。すると、情報量とは、「その情報によって、ある物事が起こる不確実さがどの程度減ったか」を表す指標です。

結論から言えば、

ある事象Aが確率pで起きる場合、Aが起きたことを知ることによって得られる情報量は、-log_2 p(ビット)と表わされます。なぜ、このように、 log で表されるかの詳細は、情報理論の参考書を参照して頂ければと思います。

例えば、ある事象Aが 1/(2^m) の確率で起きる場合、「Aが起きた」という情報の持つ情報量は、-log_2(1/(2^m)) = m(ビット)となります。この分だけ曖昧さが減った、ということです。

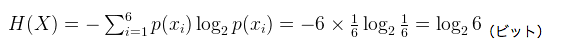

また、ある事象Aが、ある確率で起きる個々の事象の集まりa_i](i = 1 〜 m)からなる場合(例えばサイコロはそれぞれの目が1/6の確率で出る)、個々の事象の結果を知った時に得られる平均の情報量は、それぞれの事象が発生する確率を重み付け平均した値になります。これを「平均情報量(エントロピー)」と呼び、下記のように表されます。

例えば、サイコロを振る場合、出る目の数字を確率変数 X で表すと、

なので、エントロピーは、

となります。つまり、この値がサイコロの目の値を知った時に得られる平均の情報量を表しています。

このように、エントロピーは、「確率変数が実際にどんな値をとるかの曖昧さ」を表す指標であり、確率変数の値を知る(=情報量を得る)ことにより、曖昧さが減少する(=エントロピーが減少する)と言えます。

サイコロの場合なら、出た目の数を知る(=log_2 6の情報量を得る)ことによって、曖昧さがなくなる(=エントロピーが0になる)ということです。

では、この確率変数やエントロピーは、画像とどう関係するのでしょうか?

画像においては、画素値が確率変数に相当します。

つまり、その画像において、どの画素値がどの程度の確率で現れるのか、という情報の問題に読みかえられるわけです。

この場合、エントロピーは、「画素値が実際にどんな値をとるかの曖昧さ」を意味するわけですから、エントロピーが大きい画像とは、画素値のばらつきが大きい画像ですね。逆に、真っ白や真っ黒の画像は、エントロピーが小さいと言えます。

② 相互情報量

では次に、このエントロピーの考え方に基づく、相互情報量について見ていきましょう。

相互情報量は、相互というだけあって、2つの事象に関わる概念です。ここで、全く別系列だが、互いに関連している2つの事象をA, Bとした時(例えば、A:風邪か風邪でないか、B:熱があるかないか)、エントロピー H(A),H(B) は、それぞれ、Aという事象が持つ曖昧さとBという事象が持つ曖昧さを意味します。

ここで、Bの実際の結果を知った上でのAの曖昧さを H(A|B) と定義し(これを条件付きエントロピーと呼ぶ)、相互情報量 MI(A,B) を下のような式で表します。

と表されます。

つまり、この相互情報量は、「Bの実際の結果を知ることによって得られるAについての情報量」を意味します。

上の例で言うなら、「検温することによって得られる風邪についての情報量」ということになりますね。

これで相互情報量を定性的には理解できたかと思います。

では、実際にエントロピーの定義式に基づいて数式で表してみましょう。

エントロピーの定義式から、

上の2式を前述の MI(A,B) = H(A) – H(A|B) に代入して整理すると、

これが、事象AとBの相互情報量を表す数式です。

p(a_i,b_j)は、同時確率と呼ばれ、 a_i と b_j が同時に起こる確率を表し、 p(a_i),p(b_j) は、周辺確率と呼ばれ、 a_i[ と b_j それぞれが起こる確率を表します。(導出の詳細は、文献[1]参照。)

では、画像において、相互情報量はどのように表現されるでしょうか?

前述した相互情報量の定義により、

「画像Aの画素値を知ることによって得られる画像Bの画素値についての情報量」ということになります。

これはまさに、相互情報量が2つの画像の相関を表していることを示しています。例えば、2つの画像が全く同じならば、相互情報量(相関)は最大になり、2つの画像が全く無関係ならば、相互情報量(相関)はゼロになりますね。

次回は、実際のMRI画像を用いて相互情報量を計算し、画像の類似度を推定してみようと思います。